第二部分插件使用以及人设文档创建

2.插件使用教程

截止到5月24日,插件版本号是1.2.0

插件提供了多样化的指令:

- [oob]

- [oob.check]

- [oob.del]

- [oob.list]

- [oob.load]

- [oob.reset]

- [oob.tag]

- [oob.undo]

我们先来看看配置页面:

apiURL是用来填写你的oobabooga的api地址的。想要开启oobabooga的api,请看楼上。

用户使用逻辑如下:

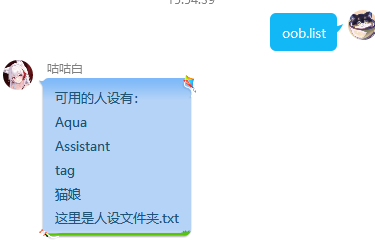

首先我们先试用oob.list指令查看当前的人设

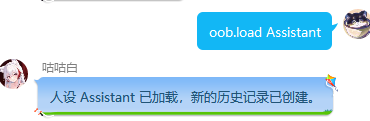

然后我们使用oob.load指令,加载我们想要使用的人设

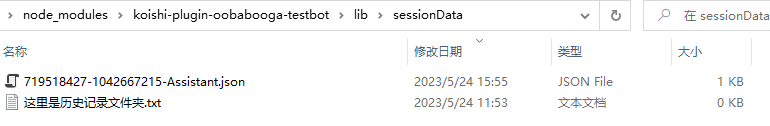

在插件文件夹内,将会创建一个新的历史记录

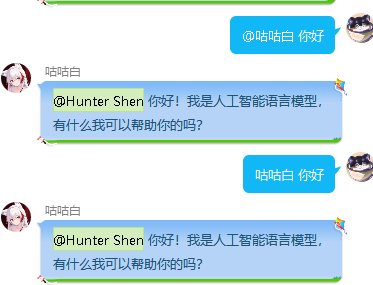

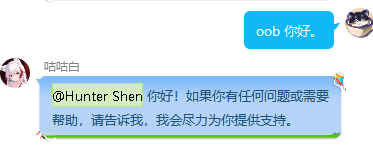

然后我们才可以使用oob与模型进行对话

oob指令是基础指令,通过使用oob指令可以直接与模型对话

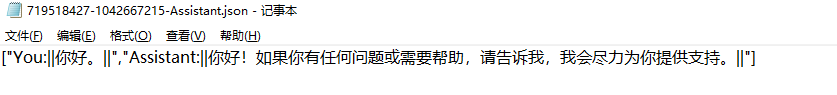

历史记录将会实时保存在对应文件内,同时historylimit将会限制上下文长度,具体取决于你的设置。

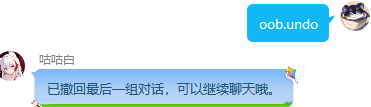

使用oob.undo指令,可以撤回刚刚的一个提问

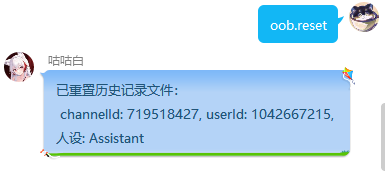

使用oob.reset指令,可以重置当前会话的历史记录

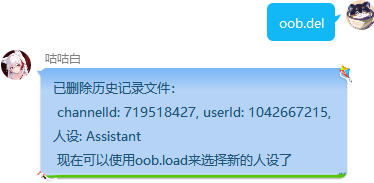

使用oob.del指令,可以删除当前的会话,来加载新的人设。

oob.tag指令可以,让Ai帮助补充tag,进行绘图。

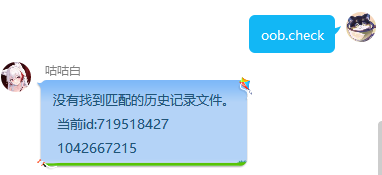

oob.check指令是一个检查指令,它会检查是是否已经存在会话了

现在的插件已经支持昵称与@唤醒