视觉模块使用教程:

首先你需要去git clone这个:

然后,你需要安装这个的环境,也就是pip install requirements

建议用conda进行环境隔离(或者使用tgw最新的懒人包也行,懒人包环境是满足需求的,不需要下载任何依赖,直接使用更目录的cmd_windows.bat进入懒人包环境即可)

然后你需要去下载模型:

下好之后全部文件都放一个目录就行。

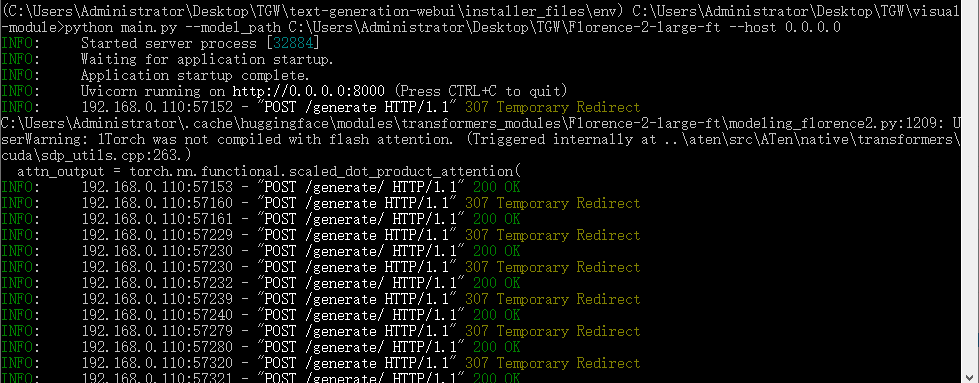

接下来,你需要在你的环境内,运行

python main.py --model_path 模型路径(到文件夹)\Florence-2-large-ft --host 0.0.0.0

就可以使用GPU进行推理了。需要额外的1-2g显存。

你想要用cpu的话可以使用(amd一些老型号不行,比如我的3900x):

python main.py --model_path C:\Users\Administrator\Desktop\TGW\Florence-2-large-ft --host 0.0.0.0 --device cpu --dtype bfloat16

如果无法正常运行,考虑就是cpu不支持bfloat16,可以用下面这条:

python main.py --model_path C:\Users\Administrator\Desktop\TGW\Florence-2-large-ft --host 0.0.0.0 --device cpu --dtype float32

但这样就需要10g左右的内存,然后cpu运算速度比较慢,会导致延迟。

启动后:

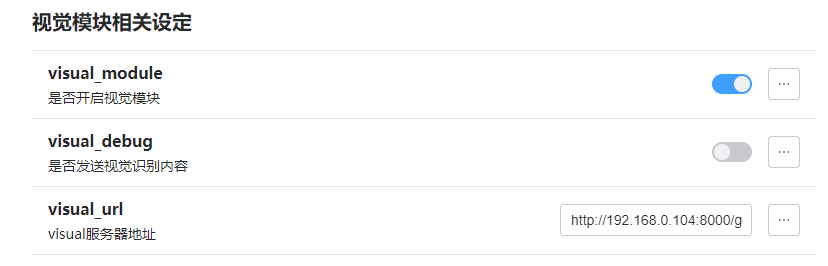

插件里头配置一下(我这里是本地服务器,所以填的服务器ip,你要全是一台机子的话,直接http://127.0.0.1:8000/generate 就行),记得必须加/generate

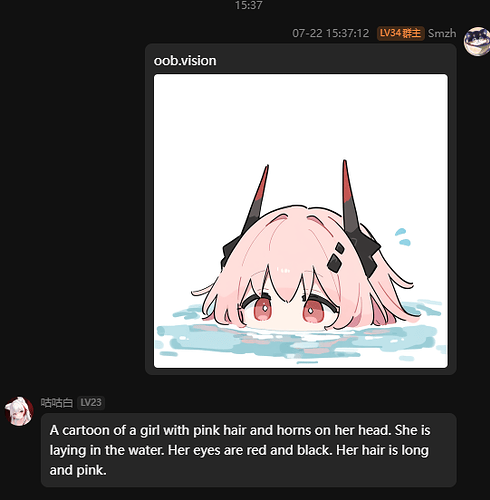

然后随便找个图片用oob.vision测试一下,就行了。