oobabooga-testbot

更新:oobabooga-testbot(3.5.5→3.6.0)

支持接入emb向量库,理论模型记忆能力+∞

新版本新增:

修复历史记录存储bug,改进工具调用格式

新增模块:向量库长期记忆系统

emb模块:

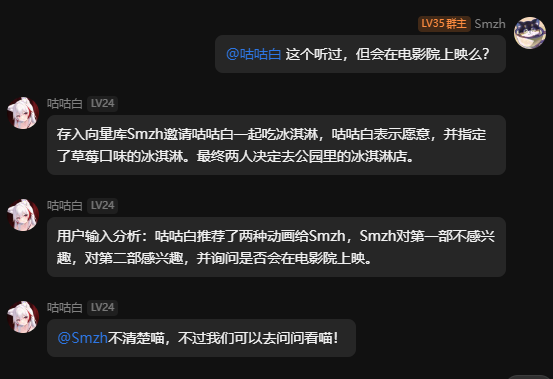

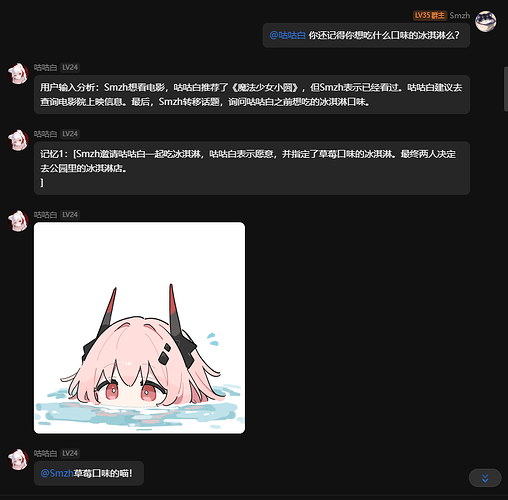

采用emb向量库系统,将用户输入进行分析总结,将模型上下文进行分析总结,可以通过语意试试读取记忆库中的相关数据。

emb模块使用教程:

首先还是安装最新版的toolkit

然后你得去按照上面的视觉模型教程去下个视觉模型

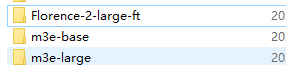

再然后你得去下这个m3e模型,这是embedding模型(其实有large和base两个版本,你要下哪个都行)

分别放在两个目录下像这样:

接下来,你需要在最新的懒人包环境内,运行

python main.py --model_path 模型路径(到文件夹)\\Florence-2-large-ft --embedding_model_path 模型路径(到文件夹)\\m3e-large --host 0.0.0.0

就可以使用GPU进行推理了。需要额外的2-3g显存。

要用CPU的话就加上上面一样的后缀就行。

插件里头一样,进行一下配置

注意 emb url里头

http://127.0.0.1:8000/embed

然后你就可以去正常聊天了。

正常来说emb系统会在模型聊天轮数超过你设定的基础的+5轮对话的时候开始自动处理,将上下文总结并加入数据库。

如果你开了debug模式,你应该可以看到这样的输出。