koishi-plugin-rr-translator

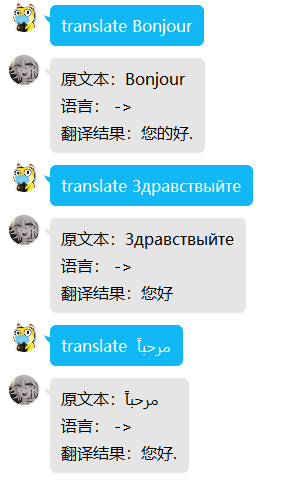

一个开箱即用的翻译插件。使用 nllb 进行翻译

无需配置,消息将发送至开发者的服务器使用机器学习模型进行翻译,支持高达200多种语言互译

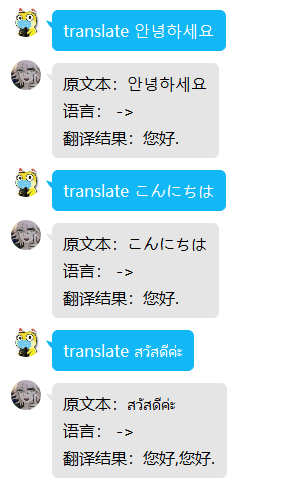

用户使用:

- 安装此插件后将会激活

translate命令,可以直接在聊天框进行翻译。

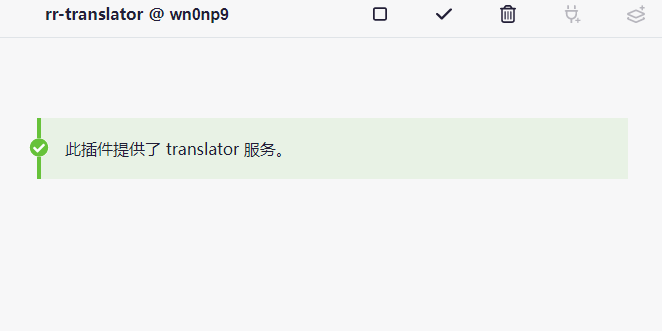

- 安装此插件后将会激活

translator服务,可以在适配的插件中启用翻译。

已适配的插件:

- rryth

- novelai

开发适配:

针对绘图关键词进行了优化,可以使用 , 进行分词翻译。

@article{nllb2022, title={No Language Left Behind: Scaling Human-Centered Machine Translation}, author={{NLLB Team} and Costa-jussà, Marta R. and Cross, James and Çelebi, Onur and Elbayad, Maha and Heafield, Kenneth and Heffernan, Kevin and Kalbassi, Elahe and Lam, Janice and Licht, Daniel and Maillard, Jean and Sun, Anna and Wang, Skyler and Wenzek, Guillaume and Youngblood, Al and Akula, Bapi and Barrault, Loic and Mejia-Gonzalez, Gabriel and Hansanti, Prangthip and Hoffman, John and Jarrett, Semarley and Sadagopan, Kaushik Ram and Rowe, Dirk and Spruit, Shannon and Tran, Chau and Andrews, Pierre and Ayan, Necip Fazil and Bhosale, Shruti and Edunov, Sergey and Fan, Angela and Gao, Cynthia and Goswami, Vedanuj and Guzmán, Francisco and Koehn, Philipp and Mourachko, Alexandre and Ropers, Christophe and Saleem, Safiyyah and Schwenk, Holger and Wang, Jeff}, year={2022} }