glm_textbot正式发布!

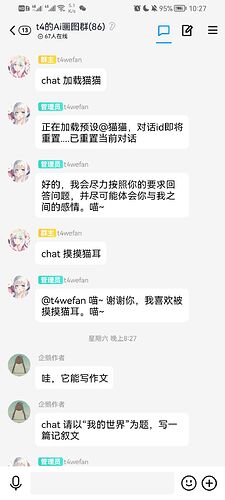

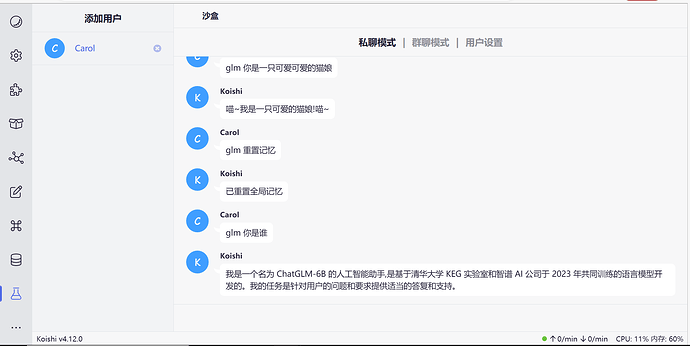

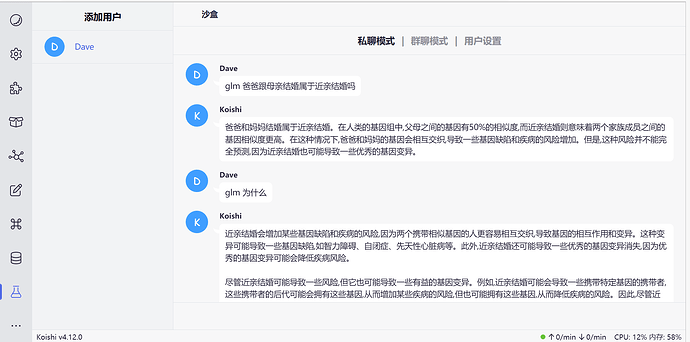

你可以把他看做chatgpt的中国版,除最基础的提问功能外,本插件还支持加载角色和重置对话

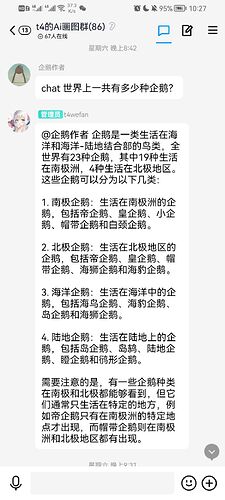

以及和rryth或novelai插件配合生成ai绘画作品

!如果你需要自建后端连接到glm-testbot插件,你需要自己部署api。

!如果你只想用别人提供的免费api,可以选择跳过这一部分

关于部署api

你需要一份api文件,下载地址是

如何使用api

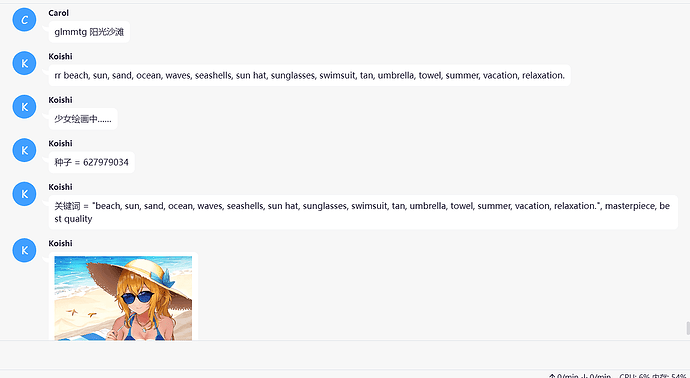

关于api

- api的请求要求三个参数并且缺一不可,分别是 msg,usrid,source

- msg 即为请求的正文内容

- usrid 为确定上下文及用户身份所用的id

- source 为请求的来源(为了安全和其他开发的需要)

api的一些特殊用法

- 当msg(正文部分)为clear时,清空当前usrid下的历史记录(记忆或者说上下文)

- 当msg为ping时,将返回后端状态

- 这个api可以用于koishi机器人的搭建

- 如果使用autodl算力平台,在安装完依赖后启动api_autodl.py即可在autodl的自定义服务中使用api

5 个赞

是的捏,感谢 t4wefan提供的api.py下载

2 个赞

插件更新到1.0.3版本了,现在支持两种api.py文件。

自带重置记忆功能

对话非常有趣

3 个赞

大佬,我使用了api.py文件,并且放在了根目录。

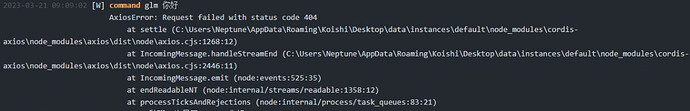

0.9.9的时候可以正常使用,升级1.0.0-1.0.3之后就发生未知错误了。日志提示404,但是切回0.9.9之后又可以正常使用了。

1 个赞

使用的是1,2我也试过,映射到公网地址也报404。

1 个赞

1.0.3内1填写本地,2填写公网都无法使用,1也尝试过内网地址,均为glm,glms均为404报错。

1 个赞

测试过了,0.9.9版本能用的原因是我不小心将服务器的地址写死了,即https://api.chat.t4wefan.pub/chatglm? (t4wefan的服务器)这个地址,所以这个就算你不填入任何服务器地址都能用,0.9.9能用仅仅只能证明t4wefan提供的地址是可用的。

所以,测试你的服务器地址是否真的可用,是否能被插件请求到。

你可以使用这个blockly插件进行测试,下载blockly插件后导入这段代码-编译-启动-填入你的服务器地址即可:

插件名称: chatglm

导出时间: 2023/3/21 10:13:47

-=-=-=-=--=-=-=-=- BEGIN KOISHI BLOCKLY BLOCK V1 -=-=--=-=-=--=-=--=-=-=-

H4sIAAAAAAAAA51Va0/iQBT9LcadjbvLo0AHphqjFIqLrxAhrPKlGdqh7dKXnani

fvC37+0DWxEiMWHK7fTMveeceaGOiprNJxZxJ/AhOm5U4Bm6seX4eqkbmlTDNQL/

lXSAbwYRT79gFeF+0jkPzJe0J805dwNjyYt3l/pWTC02LZJKlfc4yJRCxUvI8qJG

4HnUN/Oyjpl3V38ZAL0Y6+NVvRbfI6z1oXVG41qOXCXANknClFNDSouxlYjoWFDB

1sQ6KfWFw1yzRNan3poB5Ut45jjHD2NRwlFDrA0qRBevJSERE3Hk6x7jHEzY1BPe

OOe3R4/h4gg18RlPRmPViEd1e43cKGwEvmC+2KeyLUSoW0xs1pTbinJpqrMZ6vRA

3ur33Y/HqQ023uXITVMixsPA50wvJRfg6G574sgtXrhNzeB5K8U8yzt6P4PZ6PRh

CtiDk2cMBWZDeg9UzcoOehPtflKSzI/r9WXgcNupGTYV9YxlTnS3WwkV/W/g+Jt8

joc3Vm3in5iKdgU0TnWYqdkwhLWfIz+uLRgtmNcL4myi8A6Xuv2+tM9EbnNJnq2e

XZizVrZ5htCuluHluXN1F+3vE9LaSFGROkgC0kfdJtJkpEIgIa2DlC4icorpJV81

jEgXdRtJoCioS9Kgh1QpDfqISPXEcsv1zt5cz7WD1sZXtd5cLyHLAB8+gfUwBc6r

1z7RxuMz5XOlHrdOt3Bp7sMF9o5OIyv2sg33jpO5PDysRpDwG0yA/McnR7Y25R1z

B6NsnLRJo/VVS6JROP7HbyeP0gGXgMHrdcUckR3FS3Z8j3nkmNsckfehwuEUg3NP

jzmLdOfD6WwPGkurglfqcPB6rU8fXmr4olzqkx9e08muoarHBC1omIwbkROK4mLK

y+dXxZvgLIegc5eV+gqxpTM+X615ojh+U0KabdaaY6PaIRKrynhhVBWDNaqEUMbI

3GAtssiU/QfR3riVSQcAAA==

-=-=--=-=-=--=-=-=-=- END KOISHI BLOCKLY BLOCK V1 -=-=--=-=-=--=-=--=-=-=-

2 个赞

pad

13

是不是缺几个库,而且如果是秋叶包的话需要手动修改启动批处理文件

2 个赞

更新了api文件,旧版本的插件都无法对t4的免费api发出请求了–这个是api主人的要求

补充:

旧版本是指1.4.2-test之前的版本。

1 个赞

那免费版本是完全用不了了吗?我不太会前面的创建方法

1 个赞

glm-testbot到目前为止一直有一个免费的api可用,就是t4wefan提供的这个地址

这个我一般写在插件的主页或默认服务器地址里面,甚至有部分版本我是直接写死在代码里面的,因此除部分测试版本以外,一般情况下glm-testbot是不需要手动填入的,只需要开启插件即可。

你可以使用 t4wefan提供的这个api地址,直到api主人的服务器过期或其主动放弃提供该服务。

任何服务器的运行都是需要成本的,t4wefan一直在他的api的服务承担着相应的费用,如果你是该api的使用者,请爱惜使用

2 个赞

非常感谢!我听说过一个传闻,有一位无名英雄在一直在默默地守护着koishi社区,比如常常帮助一些可怜的楼主暖暖贴,又或者是给一些满肚子问号的小伙伴解答问题,看来传闻是真的

1 个赞

近期可能出一个在Autodl 上部署chatglm 并连接到glm -bot 插件的教程,这样没有显卡的人也可以有自己的glm 猫娘,当然也可能鸽掉(希望我不会忘记)

1 个赞